在当今信息爆炸的时代,文本处理成为各类应用的基础需求,而中文分词作为文本处理的第一步,其重要性不言而喻。本文将全面解析Java环境下中文分词的技术实现,带您从基础原理到实战应用,掌握这一核心技术。

一、中文分词技术概述

中文分词(Chinese Word Segmentation)指的是将连续的中文字符序列切分成有意义的词语序列的过程。与英文等拉丁语系语言不同,中文文本没有明显的词间分隔符,这使得中文分词成为自然语言处理中的特殊挑战。

1.1 分词的基本原理

中文分词的核心任务可以归纳为:给定一个汉字序列,找出最可能的切分方式。例如:

输入:"我爱自然语言处理"

输出:"我/爱/自然语言/处理"

1.2 主要技术难点

- 歧义消解:如"发展中国家"可以切分为"发展/中/国家"或"发展/中国/家"

- 未登录词识别:如新出现的网络用语、专业术语等

- 分词一致性:不同场景可能需要不同的分词标准

二、主流分词算法解析

2.1 基于词典的分词方法

这是最传统也最常用的方法,主要包含:

- 正向最大匹配法(FMM)

- 逆向最大匹配法(RMM)

- 双向最大匹配法

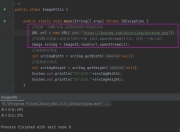

// 简单正向最大匹配示例

public List<String> FMM(String text, Trie dict, int maxLength) {

List<String> result = new ArrayList<>();

while (text.length() > 0) {

int len = Math.min(maxLength, text.length());

String word = text.substring(0, len);

while (!dict.contains(word)) {

if (word.length() == 1) break;

word = word.substring(0, word.length() - 1);

}

result.add(word);

text = text.substring(word.length());

}

return result;

}

2.2 基于统计的分词方法

随着机器学习的发展,基于统计的方法逐渐成为主流:

- 隐马尔可夫模型(HMM)

- 条件随机场(CRF)

- 深度学习模型(如BiLSTM-CRF)

统计方法的优势在于能够更好地处理未登录词和歧义问题,但对训练数据量和质量要求较高。

三、Java主流分词工具库对比

3.1 IKAnalyzer

IKAnalyzer是最早流行的Java中文分词工具之一,特点包括:

- 采用经典的词典分词算法

- 支持细粒度和智能切分两种模式

- 词典可扩展性强

// IKAnalyzer使用示例

Analyzer analyzer = new IKAnalyzer(true);

TokenStream tokenStream = analyzer.tokenStream("", "这是一个测试文本");

// 处理tokenStream...

3.2 HanLP

HanLP是功能全面的自然语言处理工具包,其分词功能特点:

- 支持多种分词算法

- 提供预训练模型

- 功能丰富(词性标注、命名实体识别等)

// HanLP使用示例

List<Term> termList = HanLP.segment("商品和服务");

System.out.println(termList);

3.3 Ansj分词

Ansj是一个基于n-Gram+CRF+HMM的分词工具:

- 速度快

- 内存占用低

- 支持自定义词典

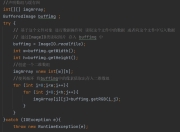

// Ansj使用示例

Result result = ToAnalysis.parse("我爱北京天安门");

System.out.println(result.getTerms());

3.4 Jieba的Java实现

Jieba虽然是Python生态的明星分词工具,但也有Java移植版本:

- 支持三种分词模式

- 基于前缀词典实现高效的词图扫描

- 支持自定义词典

// Jieba使用示例

JiebaSegmenter segmenter = new JiebaSegmenter();

List<SegToken> tokens = segmenter.process("这是一个伸手不见五指的黑夜", JiebaSegmenter.SegMode.INDEX);

3.5 Lucene Analyzers

对于使用Elasticsearch或Solr的场景,Lucene提供的中文分析器也是不错的选择:

- SmartChineseAnalyzer:基于统计的分词器

- 与搜索生态无缝集成

四、性能优化与最佳实践

4.1 词典优化技巧

- 使用Trie树或Double Array Trie存储词典

- 对词典进行内存映射(Memory Mapping)

- 实现词典的热更新机制

4.2 多线程处理

分词通常是CPU密集型操作,合理利用多线程可以显著提升吞吐量:

// 使用并行流处理分词

List<String> documents = ...;

List<List<String>> results = documents.parallelStream()

.map(doc -> segmenter.segment(doc))

.collect(Collectors.toList());

4.3 JVM调优

- 适当增加堆内存(-Xmx)

- 使用G1垃圾收集器

- 对频繁使用的词典对象进行缓存

五、实际应用场景案例

5.1 搜索引擎场景

在构建中文搜索引擎时,需要考虑:

- 索引阶段的分词策略

- 查询阶段的分词一致性

- 同义词扩展处理

5.2 情感分析预处理

情感分析前通常需要:

- 保留情感词和否定词

- 处理程度副词

- 识别特定领域术语

5.3 推荐系统中的应用

通过分词可以实现:

- 用户兴趣标签提取

- 内容特征抽取

- 查询理解

六、未来发展趋势

- 预训练语言模型(BERT等)在分词中的应用

- 领域自适应分词技术

- 多模态分词(结合视觉信息)

- 边缘设备上的轻量级分词

版权声明

本文仅代表作者观点,不代表百度立场。

本文系作者授权百度百家发表,未经许可,不得转载。